6 Ollama Kullanıcı Arayüzleri

Github ollama sayfasında, 2025 Şubat tarihi ile 110 tane web ve masaüstü kullanıcı arayüzü vardır.

6.1 Ollama UI

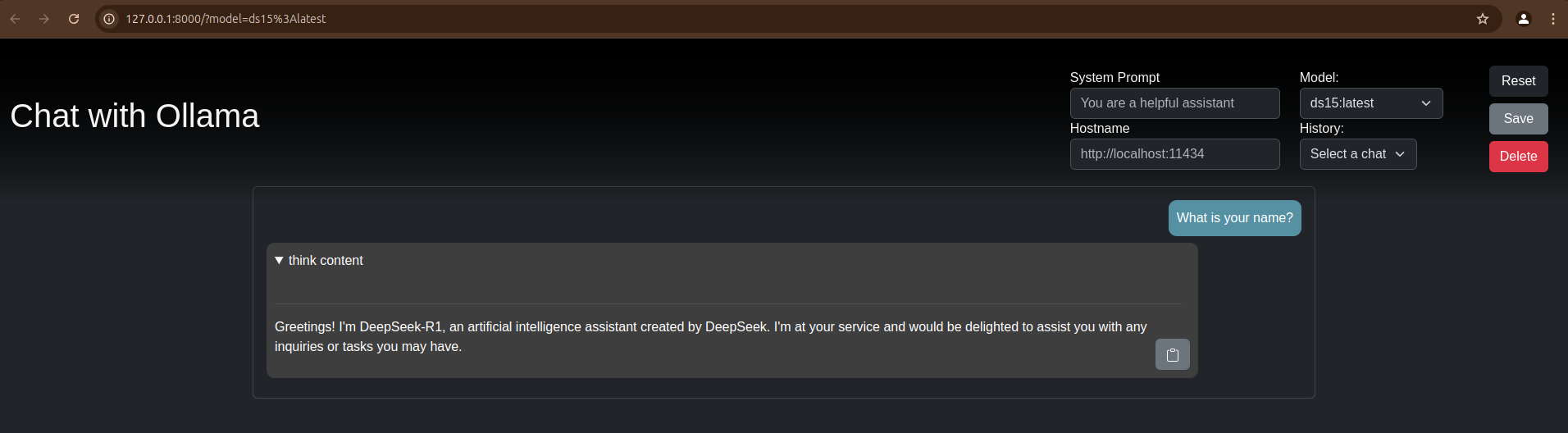

Basit ollama ui’dır. Aynı zamanda google chrome extension olarak çalışıyor. Projenin bulunduğu dizinde web server çalıştırmak gerekiyor. Aşağıdaki make komutu kullandığı bootstrap gibi 4-5 js/css dosyasını indiriyor. Projeye’de bence eklenebilirmiş.

git clone https://github.com/ollama-ui/ollama-ui

cd ollama-ui

maketarayıcıda http://localhost:8000 açınız.

Buna benzeyen bir şeyin, Vanilla JS, react, angular ile yapılması öğrenciler için güzel bir front end demo projesi olur.

6.2 Open webui

Ollama UI listesinin başında olan bu araçın özellikleri oldukça fazladır.

- Ollama/OpenAI API Entegrasyonu

- İzinler ve Kullanıcı Grupları

- Duyarlı Tasarım (Responsive Design)

- Mobil için İlerici Web Uygulaması (PWA)

- Tam Markdown ve LaTeX Desteği

- Yerel Python Fonksiyon Çağrı Aracı

- Yerel RAG Entegrasyonu

- RAG için Web Araması

- Web Tarama Yeteneği

- Görüntü Oluşturma Entegrasyonu (Yerel ComfyUI)

- backend FastAPI

- frontend svelte

6.2.1 Python paket ile open-webui kurulum

Opsiyonel olarak, paket çakışmalarını engellemek için, sanal ortam (virtual environment) oluşturun.

python -m venv venv-open-webuiSanal ortamı aktive edin.

Linux/Mac

source ./venv-open-webui/bin/activateWindows

.\venv-open-webui\Scripts\activate.batArkasından open-webui paketini kurun.

pip install open-webuiAşağıdaki komut ile çalıştırın.

open-webui serveBu kullanımda çok fazla dosya indiriliyor ve docker kullanımından daha zor.

6.2.2 Docker Open webui kullanımı

NVDIA container toolkit kurmam gerekti.

Kendi web sitesinde aşağıdaki komut ile çalıştırmamız tavsiye ediliyor.

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:mainAma ben bu komutta sorun yaşadım.

Bunun yerine aşağıdaki komut ile çalıştırabildim.

docker run --detach --gpus all --network=host -v open-webui:/app/backend/data --name open-webui -e PORT=8081 -e WEBUI_AUTH=false ghcr.io/open-webui/open-webui:cuda Komut açıklaması

- –detach arka planda çalıştır

- –gpus all gpu kullanımına izin ver

- –network=host , çalıştığı makine ile ağ paylaşımı.

- Bu sayede ollama’ya erişim yapabiliyoruz.

- -v volume ataması yapıyor

- bu sayede docker stop, run yapılsa bile veriler saklanıyor.

- -e PORT=8081 çalıştığı port numarası değiştirmek için

- -e WEBUI_AUTH=false Bu argumanı vererek kullanıcı oluşturmayı engelliyorum. Eğer bu ortam değişkeni olmazsa ilk açılışta bir kullanıcı oluşturup her seferinde bilgilerini girmeniz gerekiyor.

Eğer bilgisayarınız tekrar başladığında open webui çalışmasını istiyorsanız aşağıdaki argumanı ekleyin.

- –restart always

docker run --detach --network=host -v open-webui:/app/backend/data --name open-webui -e PORT=8081 -e WEBUI_AUTH=false ghcr.io/open-webui/open-webui:cuda OLLAMA_BASE_URLS ENABLE_OLLAMA_API

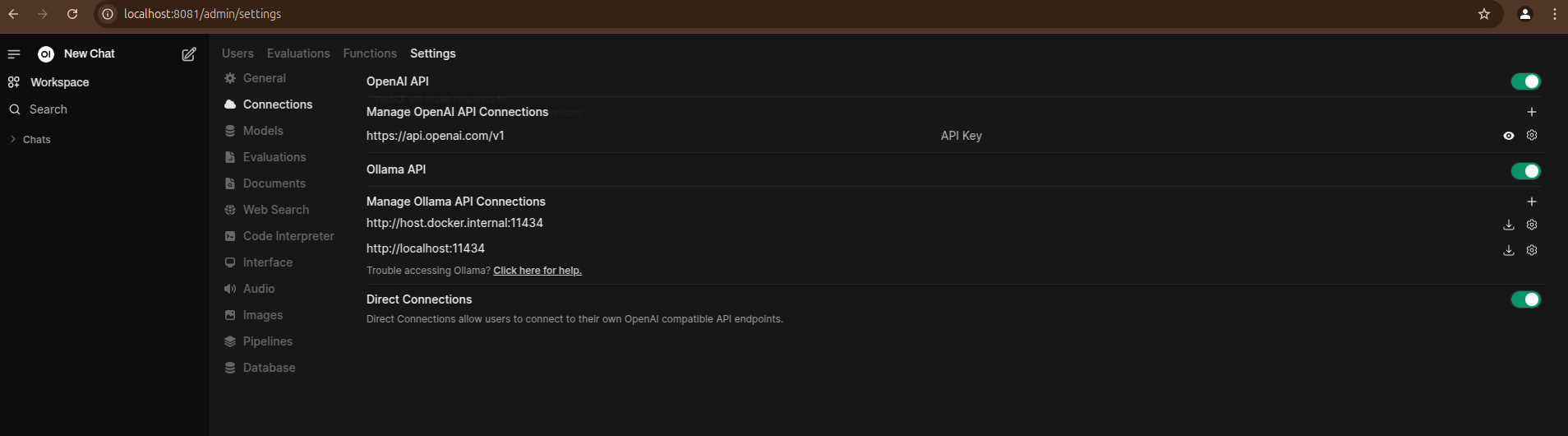

İlk çalıştırdığımızda, ollama bağlantısıını düzeltmemiz gerekiyor. Sağdaki menüden settings, admin settings seçiniz. Arkasından connections üzerinde

- http://host.docker.internal:11434

değerini

- http://localhost:11434

yapınız. Eğer ilk verdiğim komut ile open-webui çalıştıysa bu bağlantı değişikliğini yapmanıza gerek yoktur.

Eğer bu değişikliği yaptıktan sonra hala Ollama modellerinizi göremiyorsanız. Aşağıdaki komut ile docker container bash açınız.

docker exec -it --name open-webui bashBurada aşağıdaki komutu çalıştırınız.

curl http://localhost:11434sonuç olarak aşağıdaki gibi Ollama’nın çalıştığını görmeniz gerekir.

Ollama is running

Eğer görmüyorsanız, ya Ollama’yı ollama serve ile çalıştırmayı unuttunuz yada docker localhost’a ulaşmıyor.

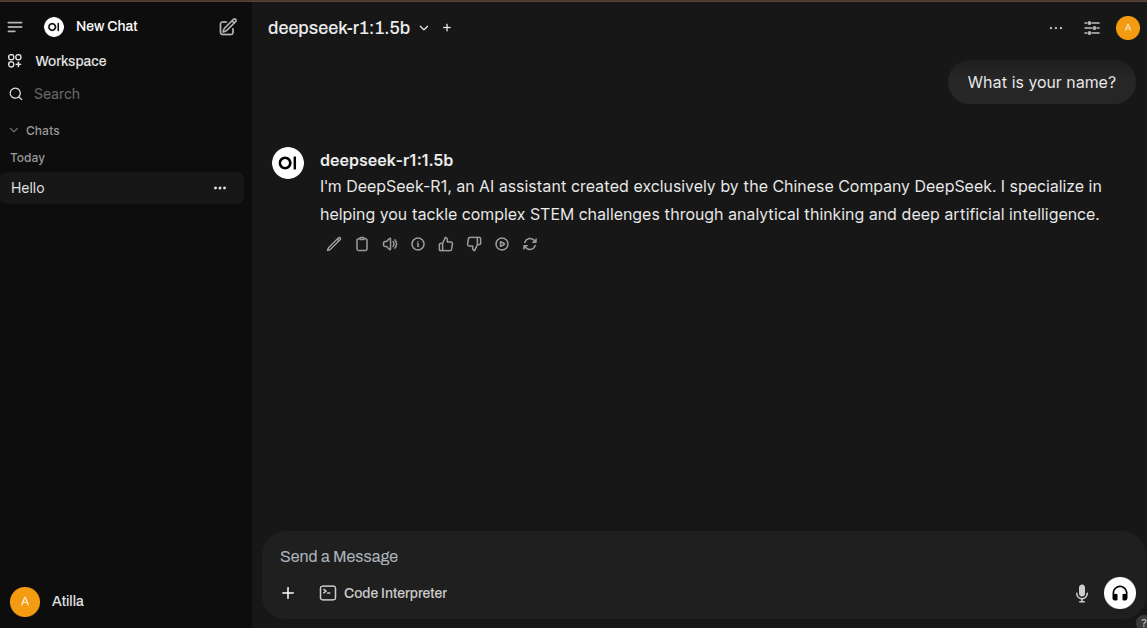

Demo

- Giriş

- Settings ollama json api uç noktası ekle

- Model seçme

- chat

- chat rename

- dokuman upload

- resim ekle

- Karşılaştırmalı chat

- değerlendirmeleri göster

6.2.3 Open webui için diğer öğreticiler

6.3 LM Studio

LM studio modelleri kendi indiren ve kendi mantığına göre çalışan bir araç.

Kurulum dosyasını işletim sistemine göre indirin.

Ollama modelleri LM studio’nun kullandığı modellere çevrilebilir. Bunu aşağıdaki betik ile yapabiliriz.

6.3.1 gollama

gollama kullanabiliriz.

Aşağıdaki komut ile gollama kurunuz

go install github.com/sammcj/gollama@HEADModelleri büyüklüğüne sıralayabilir. Silebilir.

gollamaAşağıdaki komut ile ollama modellerini lmstudio’ya bağlayabiliriz.

gollama -link-lmstudio6.4 gpt4all

MIT License olduğu için istediğiniz gibi kullanabilir ve değiştirebilirsiniz.

Kurulum dosyasını işletim sistemine göre indirin.

Linux

flatpak ilede kurulum yapabilirsiniz.

çalıştırın.

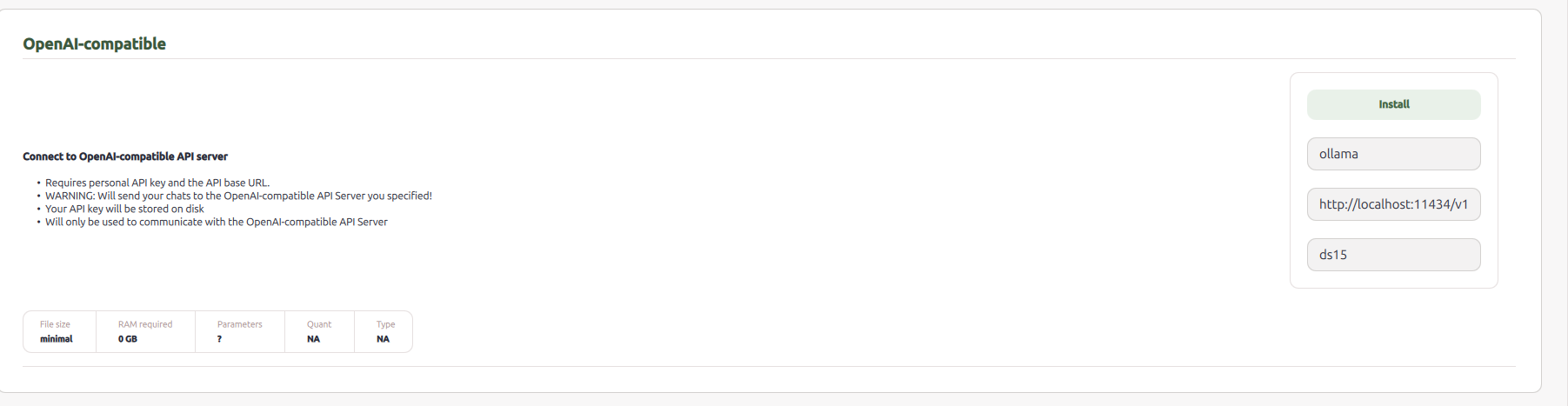

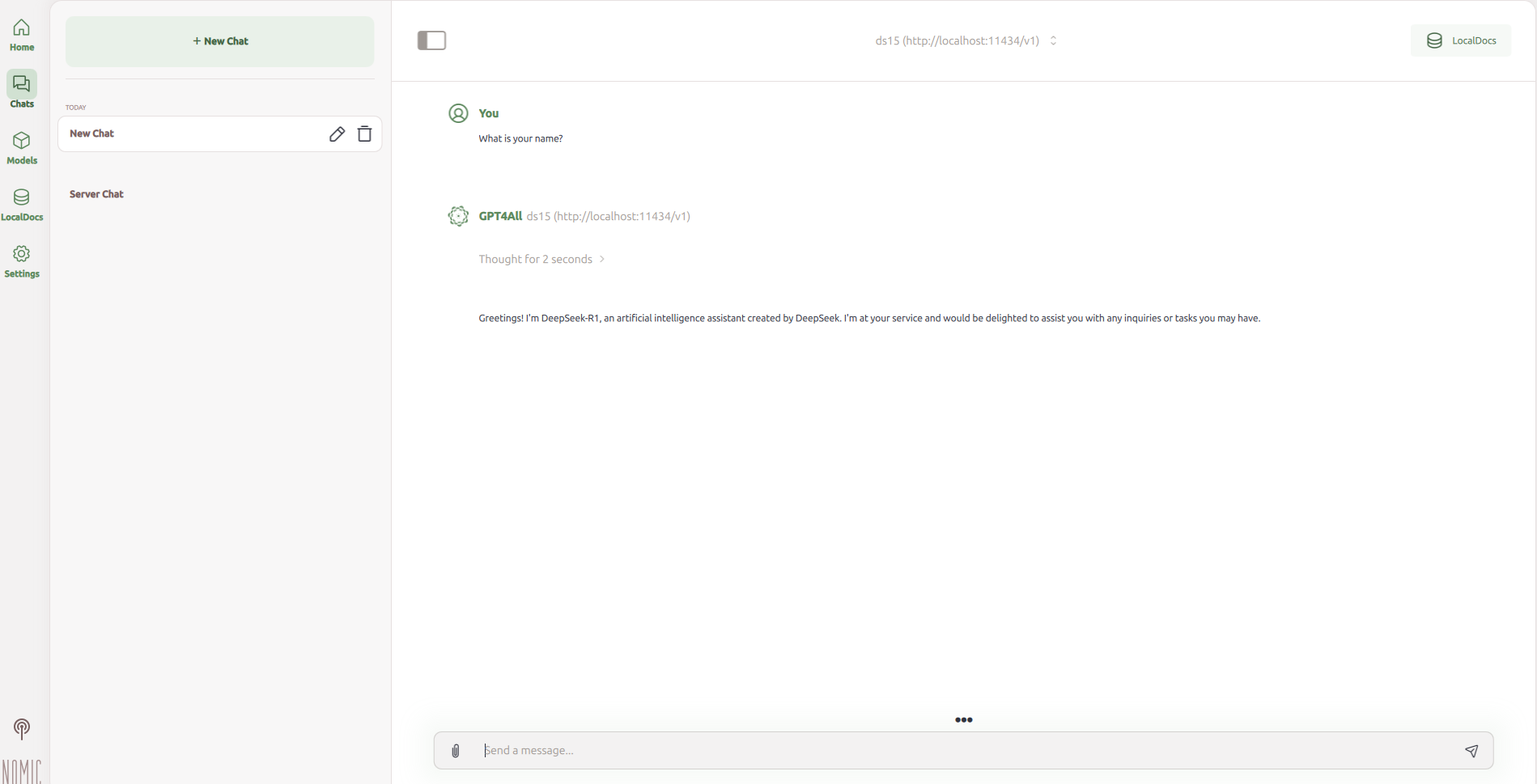

Normalde kendi modellerini çok kolay bir şekilde indirebiliyorsunuz. Ama ollama ile kullanmak için Open AI compatible model olarak eklemeniz gerekli.

Normal kullanımı kolay olabilir ama ollama entegrasyonu zor. Birden fazla model ekleyemedim. Ollama ile kullanım için tavsiye etmiyorum.

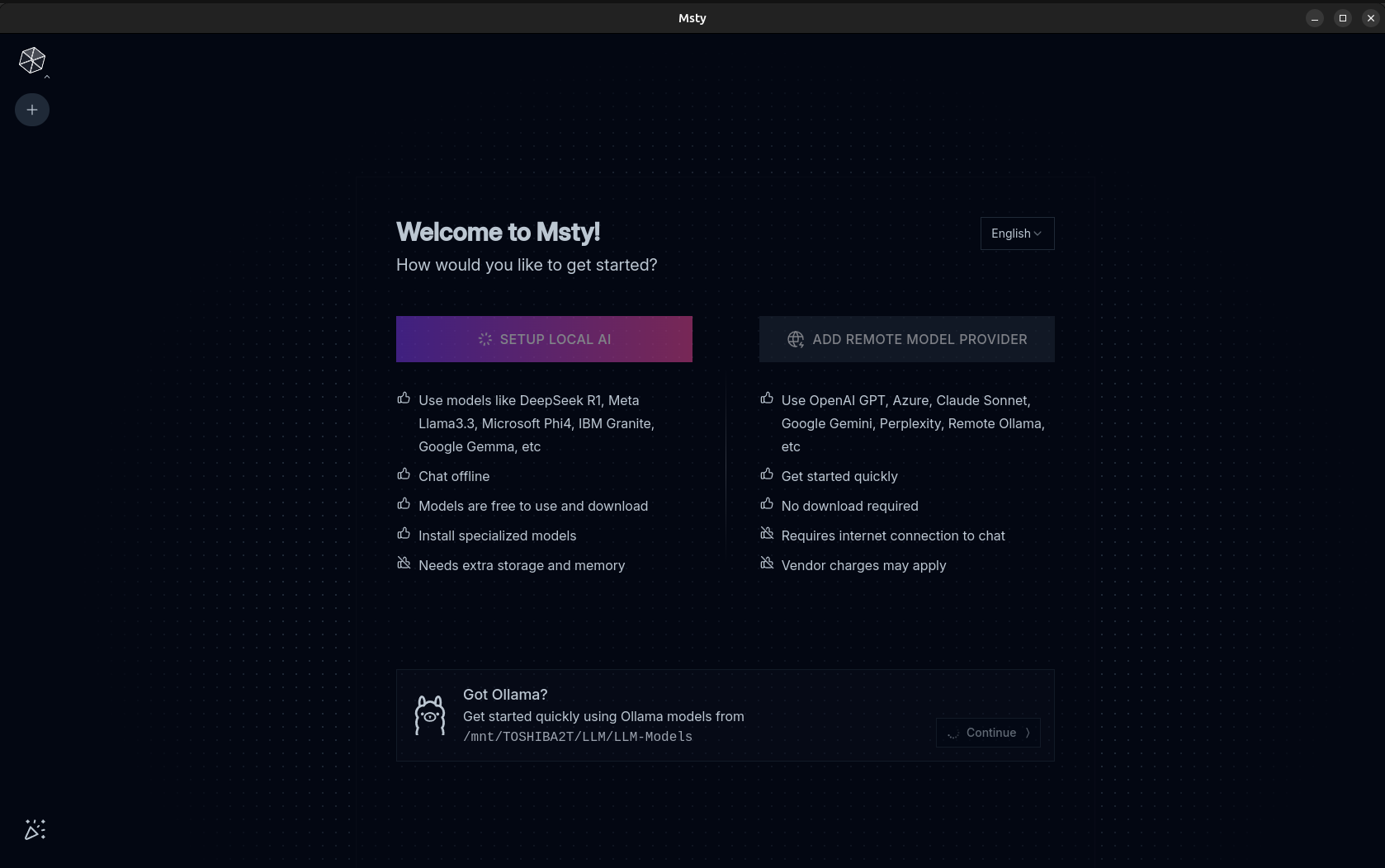

6.5 Msty

Açık kaynak değil. Bundan dolayı üstüne yazılım geliştirmeye uygun değil. Ama

- bağlantısız ilk, bağlantılı hazır (Offline-First, Online-Ready)

- RAG

- Farklı LLM sohbetlerini karşılaştırma

- Ollama entegrasyonu

- Dosya ekleme

- Sohbet dizinleri

- Süfle kütüphanesi (prompt library) sunuyor.

gibi daha bir çok güzel özelliği var.

msty web sitesi uygulamayı indirin.

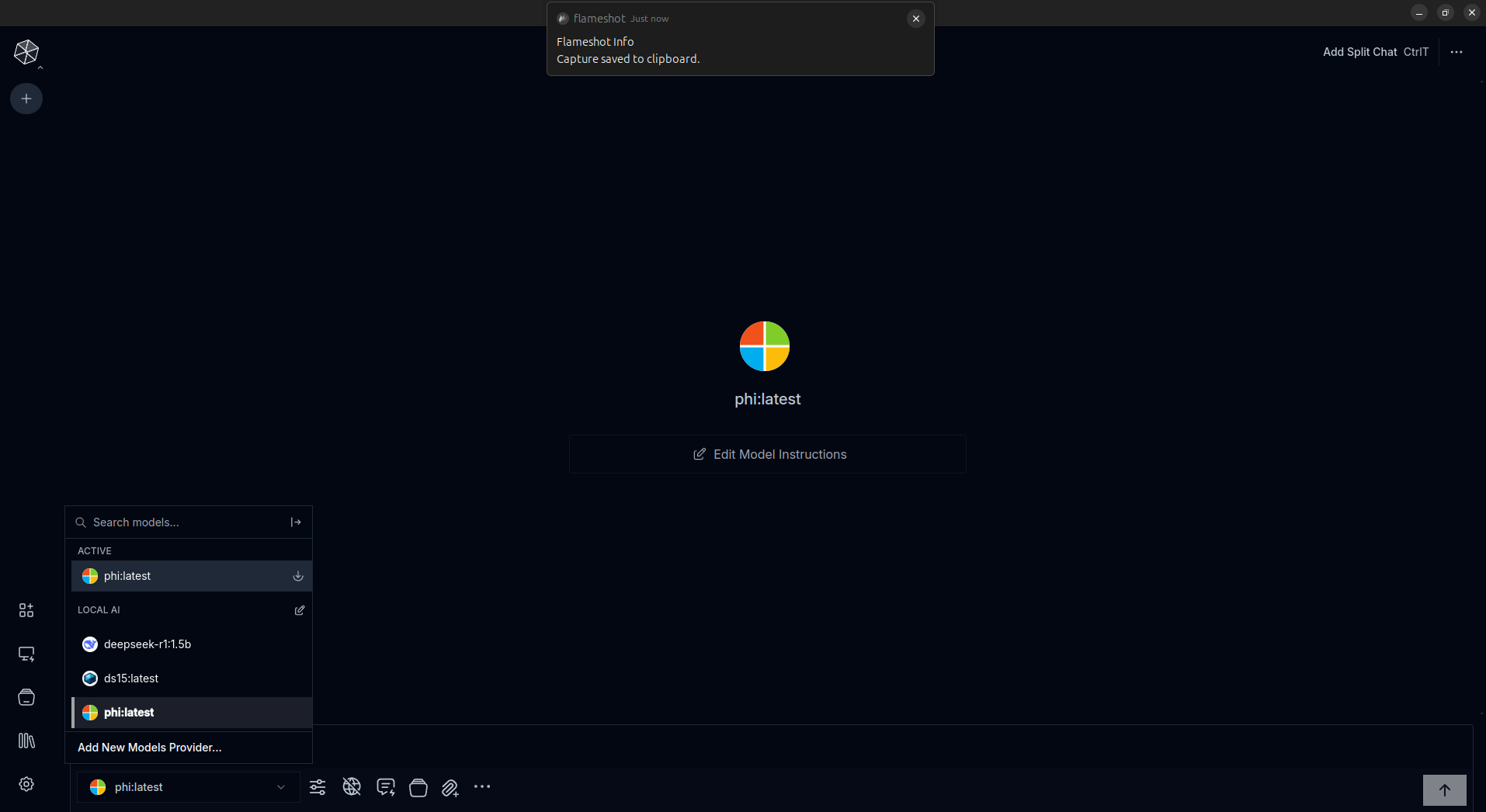

Daha başlar başlamaz Ollama modellerini görüyor.

Yüklü ollama modellerinden birini seçerek sohbet yapabilirsiniz.

Demo

- Ollama ile sohbet

- Sonuçlarda ayrı sohbet ile bilgi alma

- Ayrı modelleri karşılaştırma

- Görselleştirme (Visualizing Branches)

- Sohbet dizinleri

- Süfle kütüphanesi

- RAG: Knowledge stacks

- Tek dokuman ile konuşma

- Web araması

- Uzak modeller (Remote Models)

6.5.1 Msty için diğer öğreticiler

6.6 AI-Studio

.NET uygulaması

Kurulum dosyasını işletim sistemine göre indirin.

MIT License olduğu için istediğiniz gibi kullanabilir ve değiştirebilirsiniz.

6.7 Chat Ollama

https://github.com/sugarforever/chat-ollama